MiniCPM

MiniCPM 是什麼?

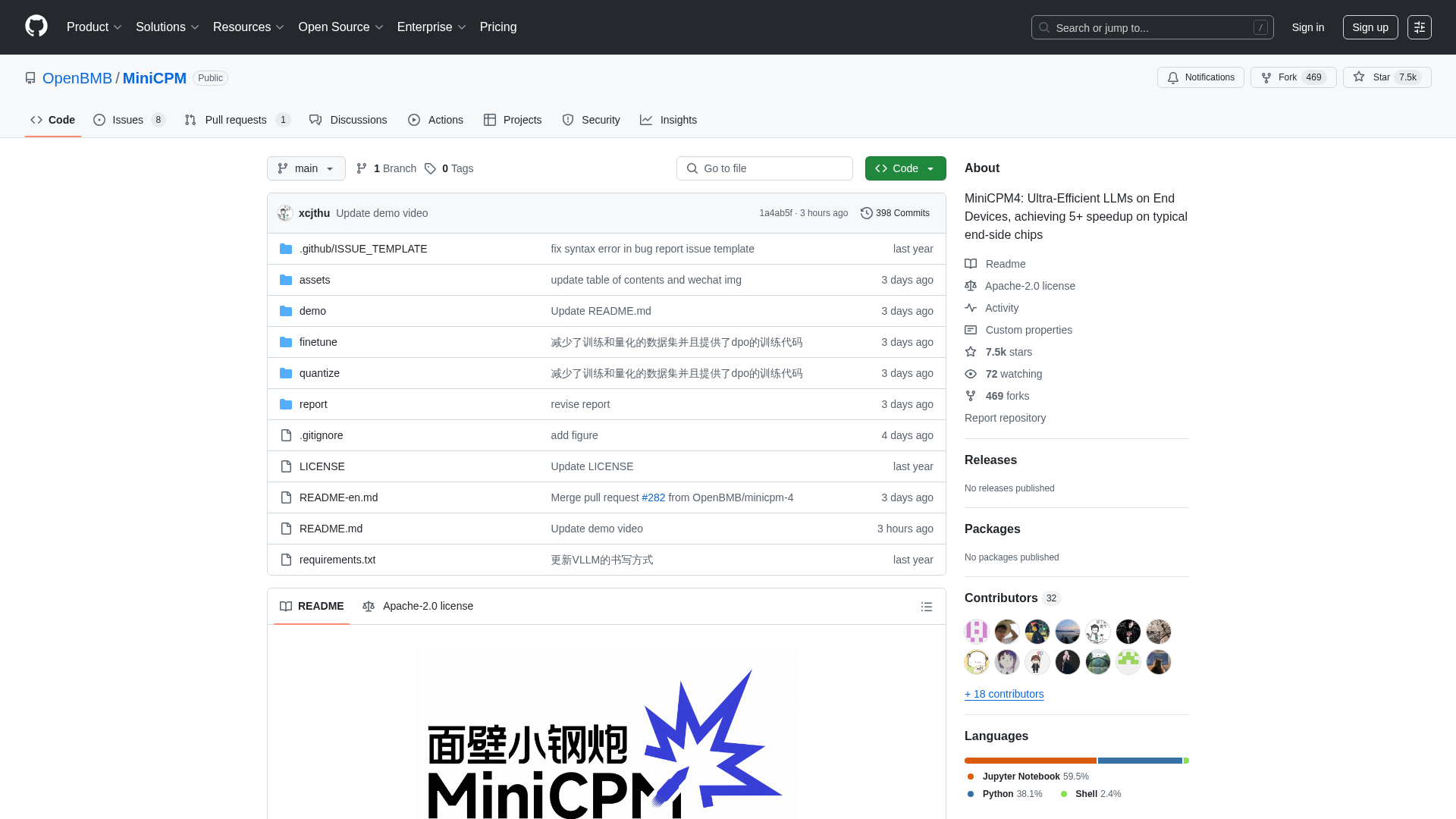

MiniCPM 是一個由 OpenBMB、THUNLP 和 ModelBest 共同開發的開源專案,提供一系列高效能的大型語言模型 (LLMs),專為在資源受限的終端設備上部署而優化。它旨在幫助開發人員、研究人員和組織,在不犧牲效能的前提下,將強大的 AI 功能整合到邊緣運算環境中。該平台提供多種模型尺寸(從 0.5B 到 8B 參數),並透過優化的架構、學習演算法和推論系統實現極致效率等進階功能,從而在長文本處理、工具調用和程式碼解釋等任務中實現卓越效能。

如何使用 MiniCPM

使用者可以透過複製其 GitHub 儲存庫來與 MiniCPM 互動,該儲存庫提供了模型權重和推論程式碼的存取權限。這些模型可在 HuggingFace 和 ModelScope 上下載。對於推論,使用者可以利用各種優化的框架,例如 CPM.cu(建議用於最大效率)、HuggingFace Transformers、vLLM、SGLang、llama.cpp、Ollama、fastllm 和 mlx_lm。該專案還提供了使用 LLaMA-Factory 等工具進行模型微調的詳細指南,以及工具調用和程式碼解釋等進階功能的說明。作為一個在 Apache-2.0 許可下發布的開源專案,沒有直接的註冊要求或定價模式;使用者可以自由下載並將模型整合到其應用程式中。

MiniCPM 的核心功能

超高效 LLM 架構 (InfLLM v2 支援稀疏注意力)

終端設備上的極致效率(5 倍以上加速)

廣泛的模型範圍(0.5B 至 8B 參數)

進階量化 (BitCPM4 支援三值量化)

長上下文窗口支援(高達 128K,透過 RoPE 縮放可擴展至 131K+)

優化推論框架 (CPM.cu, vLLM, SGLang, llama.cpp, PowerInfer)

工具調用能力 (MiniCPM4-MCP 可與 16+ MCP 伺服器互動)

程式碼解釋器功能

自動問卷生成 (MiniCPM4-Survey 代理)

高品質訓練數據 (UltraClean, UltraChat v2)

MiniCPM 的使用場景

在手機、智慧家庭設備或嵌入式系統上部署強大的 AI 助理。

開發需要即時、高效處理長文件或對話的應用程式。

建立能夠與外部工具和 API 互動的智慧代理。

自動生成學術文獻回顧或研究摘要。

將程式碼執行和問題解決整合到 AI 驅動的開發工具中。

增強檢索增強生成 (RAG) 系統以改進資訊檢索。

為計算資源有限的專業行業應用微調緊湊型語言模型。

在各種消費電子產品和工業設備中實現離線 AI 功能。

高效 AI 和大型語言模型的研究與開發。

建立需要在邊緣設備上實現高效能的客製化 AI 解決方案。