MiniCPM

| Introduction: | MiniCPM est une série de modèles de langage de grande taille (LLM) ultra-efficaces conçus pour un déploiement haute performance sur les appareils finaux, permettant des accélérations significatives et des performances compétitives par rapport à des modèles plus grands. |

| Enregistré le: | 6/9/2025 |

| Liens: |

Qu'est-ce que MiniCPM ?

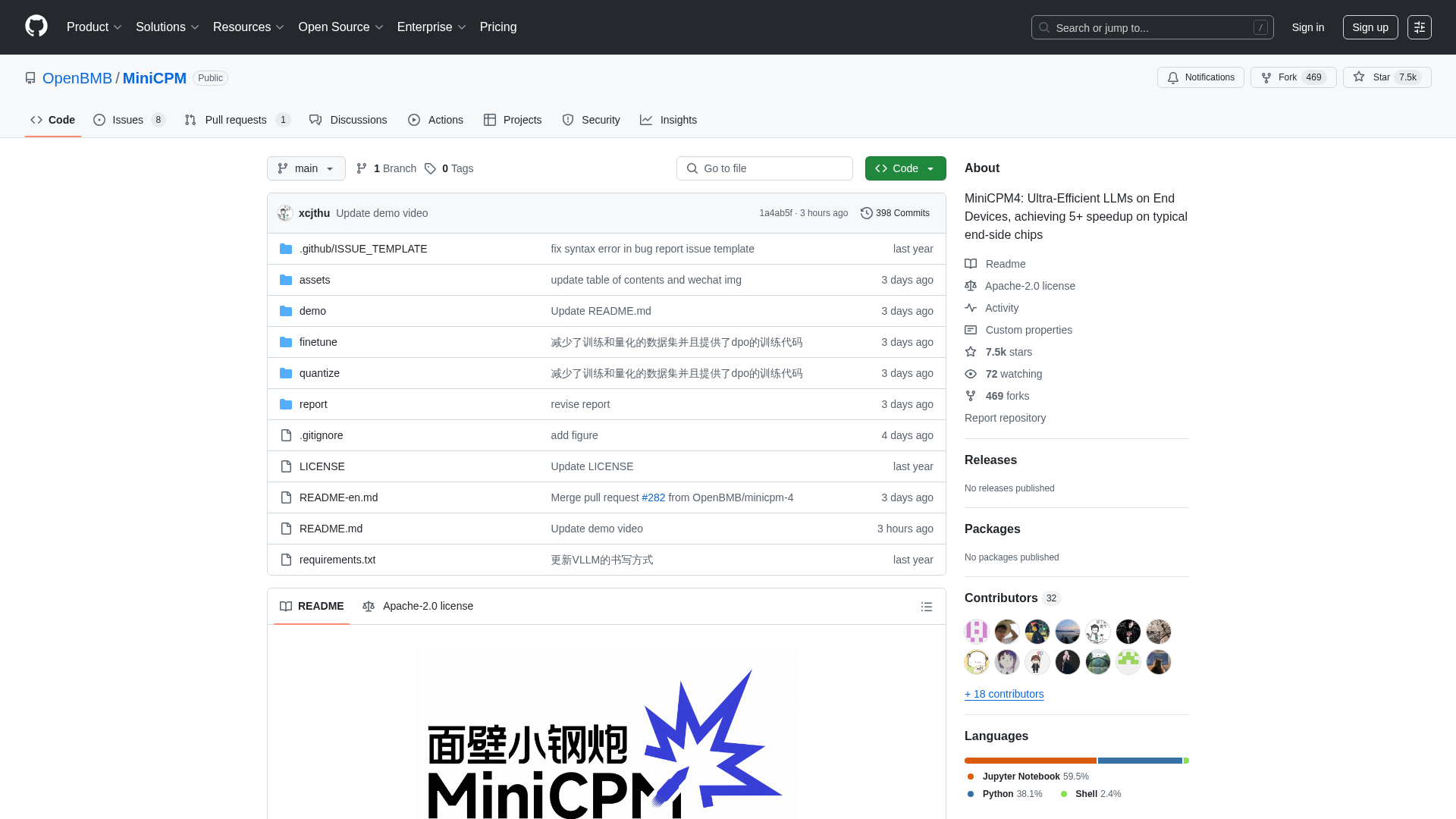

MiniCPM est un projet open source développé par OpenBMB, THUNLP et ModelBest, proposant une famille de modèles de langage de grande taille (LLM) très efficaces, optimisés pour un déploiement sur des appareils finaux aux ressources limitées. Il s'adresse aux développeurs, chercheurs et organisations cherchant à intégrer de puissantes capacités d'IA dans des environnements de calcul en périphérie sans sacrifier les performances. La plateforme offre différentes tailles de modèles (de 0,5 milliard à 8 milliards de paramètres) et des fonctionnalités avancées telles qu'une efficacité extrême grâce à des architectures, des algorithmes d'apprentissage et des systèmes d'inférence optimisés, permettant des performances supérieures dans des tâches telles que le traitement de textes longs, l'appel d'outils et l'interprétation de code.

Comment utiliser MiniCPM

Les utilisateurs peuvent interagir avec MiniCPM en clonant son dépôt GitHub, qui donne accès aux poids du modèle et au code d'inférence. Les modèles sont disponibles en téléchargement sur HuggingFace et ModelScope. Pour l'inférence, les utilisateurs peuvent exploiter divers frameworks optimisés tels que CPM.cu (recommandé pour une efficacité maximale), HuggingFace Transformers, vLLM, SGLang, llama.cpp, Ollama, fastllm et mlx_lm. Le projet propose également des guides détaillés pour le réglage fin des modèles à l'aide d'outils comme LLaMA-Factory et pour des fonctionnalités avancées telles que l'appel d'outils et l'interprétation de code. En tant que projet open source sous licence Apache-2.0, il n'y a pas d'exigences d'enregistrement directes ni de modèles de tarification ; les utilisateurs peuvent télécharger et intégrer librement les modèles dans leurs applications.

Fonctionnalités principales de MiniCPM

Architecture LLM Ultra-Efficace (InfLLM v2 pour l'attention clairsemée)

Efficacité Extrême sur les Appareils Finaux (accélération de plus de 5x)

Large Gamme de Modèles (de 0,5 milliard à 8 milliards de paramètres)

Quantification Avancée (BitCPM4 pour la quantification à 3 valeurs)

Prise en Charge de Fenêtre de Contexte Longue (jusqu'à 128K, extensible à plus de 131K avec la mise à l'échelle RoPE)

Frameworks d'Inférence Optimisés (CPM.cu, vLLM, SGLang, llama.cpp, PowerInfer)

Capacité d'Appel d'Outils (MiniCPM4-MCP pour interagir avec plus de 16 serveurs MCP)

Fonctionnalité d'Interprète de Code

Génération Automatisée d'Enquêtes (agent MiniCPM4-Survey)

Données d'Entraînement de Haute Qualité (UltraClean, UltraChat v2)

Cas d'utilisation de MiniCPM

Déploiement d'assistants IA puissants sur les téléphones mobiles, les appareils domestiques intelligents ou les systèmes embarqués.

Développement d'applications nécessitant un traitement en temps réel et efficace de documents ou de conversations longs.

Construction d'agents intelligents capables d'interagir avec des outils externes et des API.

Automatisation de la génération de revues de littérature académique ou de résumés de recherche.

Intégration de l'exécution de code et de la résolution de problèmes dans des outils de développement basés sur l'IA.

Amélioration des systèmes de Génération Augmentée par Récupération (RAG) pour une meilleure récupération d'informations.

Réglage fin de modèles de langage compacts pour des applications industrielles spécialisées avec des ressources computationnelles limitées.

Activation des capacités d'IA hors ligne dans divers appareils électroniques grand public et équipements industriels.

Recherche et développement en IA efficace et en modèles de langage de grande taille.

Création de solutions d'IA personnalisées nécessitant des performances élevées sur les appareils en périphérie.