MiniCPM

MiniCPM 是什么?

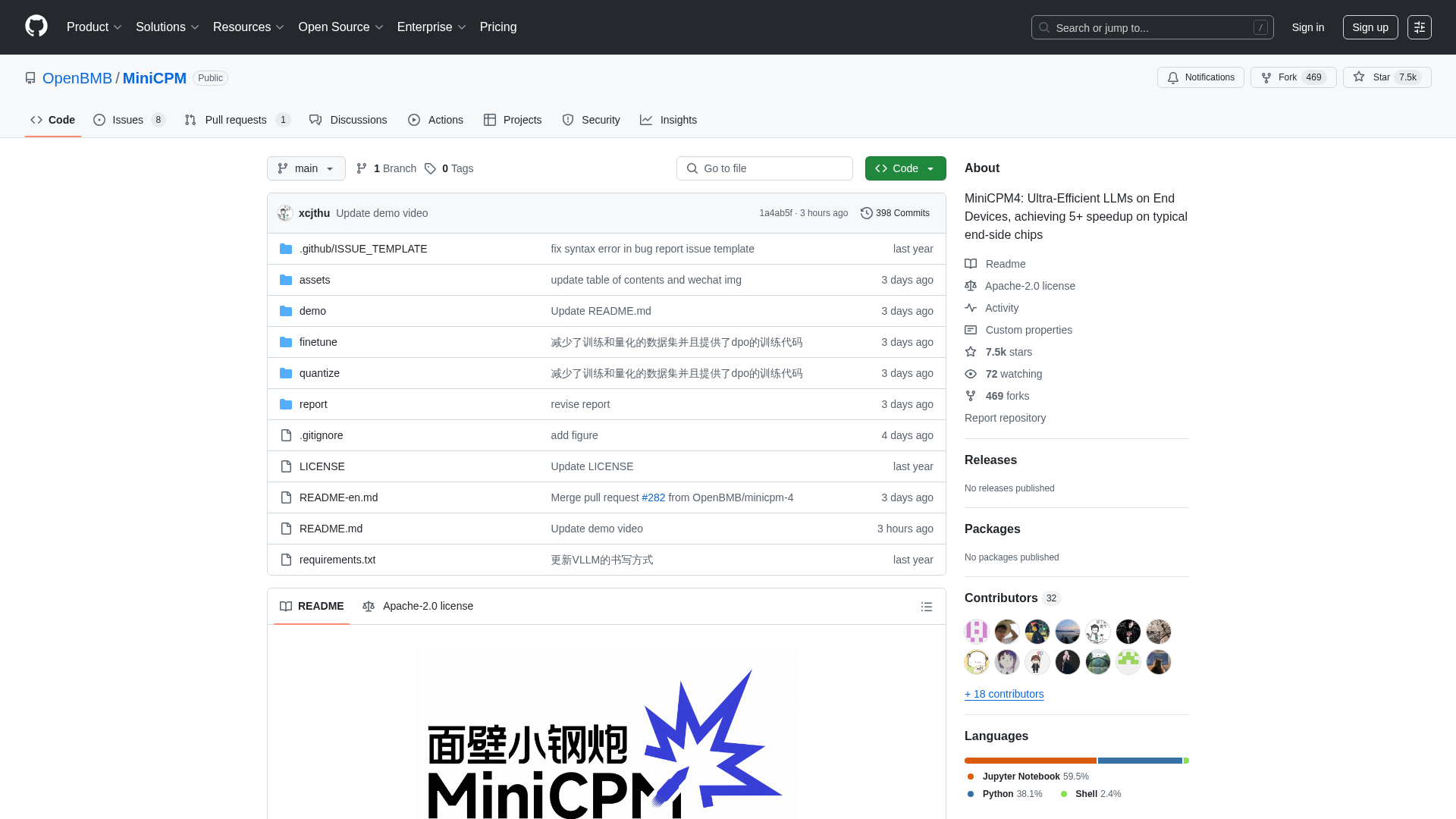

MiniCPM 是由 OpenBMB、THUNLP 和 ModelBest 联合开发的开源项目,提供一系列高度高效的大型语言模型(LLM),专为在资源受限的终端设备上部署而优化。它面向寻求在不牺牲性能的前提下,将强大AI能力集成到边缘计算环境中的开发者、研究人员和组织。该平台提供多种模型尺寸(从0.5B到8B参数),并通过优化的架构、学习算法和推理系统实现极致效率等高级功能,从而在长文本处理、工具调用和代码解释等任务中实现卓越性能。

如何使用 MiniCPM

用户可以通过克隆 MiniCPM 的 GitHub 仓库来使用它,该仓库提供了模型权重和推理代码。模型可在 HuggingFace 和 ModelScope 上下载。对于推理,用户可以利用各种优化的框架,如 CPM.cu(推荐以获得最高效率)、HuggingFace Transformers、vLLM、SGLang、llama.cpp、Ollama、fastllm 和 mlx_lm。该项目还提供了使用 LLaMA-Factory 等工具进行模型微调的详细指南,以及工具调用和代码解释等高级功能的说明。作为一个基于 Apache-2.0 许可证的开源项目,MiniCPM 没有直接的注册要求或定价模式;用户可以免费下载并将其模型集成到自己的应用程序中。

MiniCPM 的核心功能

超高效LLM架构(InfLLM v2 用于稀疏注意力)

终端设备上的极致效率(5倍以上加速)

广泛的模型范围(0.5B至8B参数)

高级量化(BitCPM4 用于三值量化)

长上下文窗口支持(高达128K,通过RoPE缩放可扩展至131K+)

优化的推理框架(CPM.cu, vLLM, SGLang, llama.cpp, PowerInfer)

工具调用能力(MiniCPM4-MCP 用于与16+ MCP服务器交互)

代码解释器功能

自动化问卷生成(MiniCPM4-Survey 代理)

高质量训练数据(UltraClean, UltraChat v2)

MiniCPM 的使用场景

在手机、智能家居设备或嵌入式系统上部署强大的AI助手。

开发需要实时、高效处理长文档或对话的应用程序。

构建能够与外部工具和API交互的智能代理。

自动化生成学术文献综述或研究摘要。

将代码执行和问题解决集成到AI驱动的开发工具中。

增强检索增强生成(RAG)系统以改进信息检索。

为计算资源有限的专业行业应用微调紧凑型语言模型。

在各种消费电子产品和工业设备中实现离线AI能力。

高效AI和大型语言模型的研究与开发。

创建需要在边缘设备上实现高性能的定制AI解决方案。