MiniCPM

| Introdução: | MiniCPM é uma série de modelos de linguagem grandes (LLMs) ultraeficientes projetados para implantação de alto desempenho em dispositivos finais, alcançando acelerações significativas e desempenho competitivo contra modelos maiores. |

| Registrado em: | 6/9/2025 |

| Links: |

O que é MiniCPM?

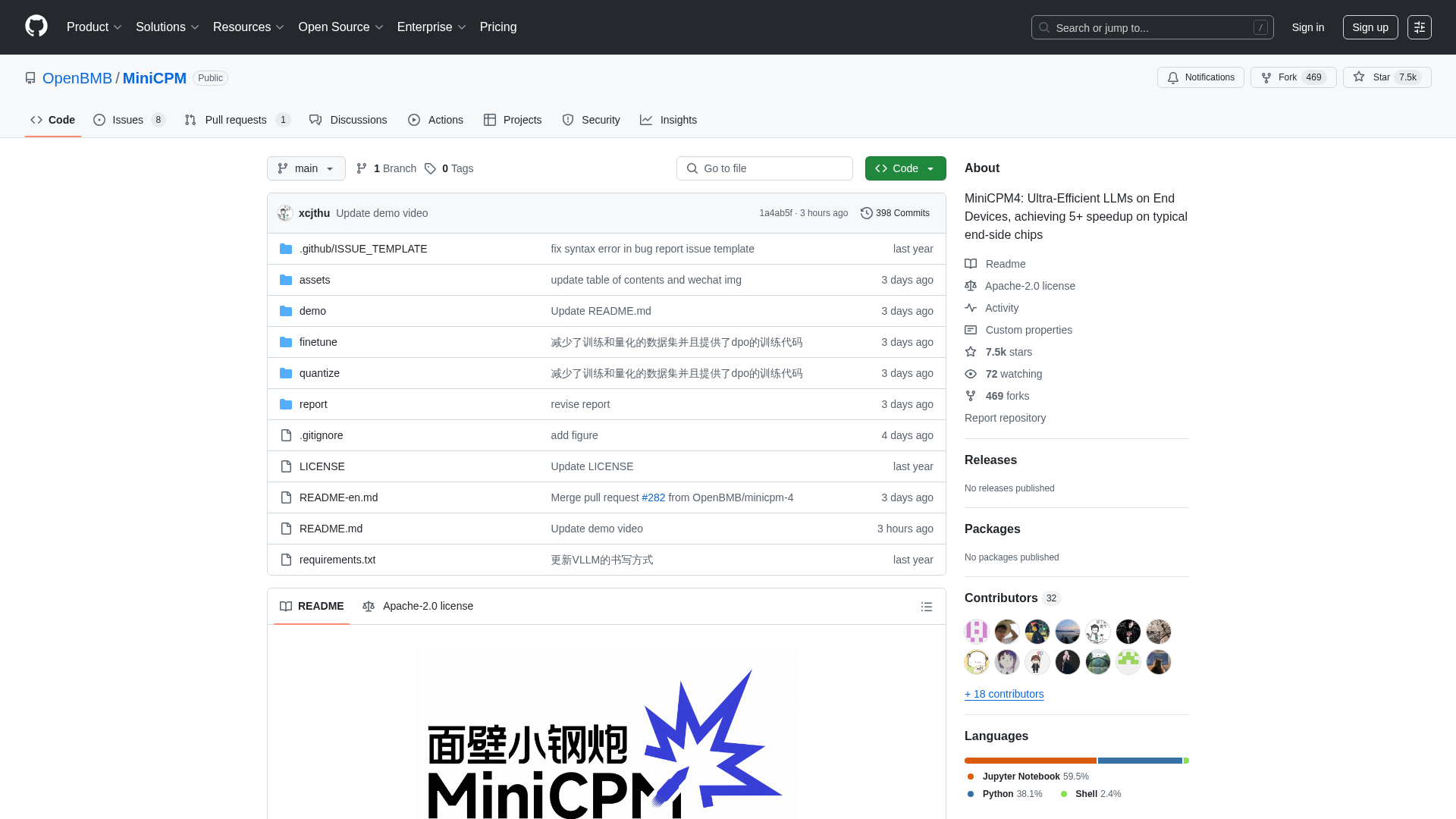

MiniCPM é um projeto de código aberto desenvolvido por OpenBMB, THUNLP e ModelBest, oferecendo uma família de modelos de linguagem grandes (LLMs) altamente eficientes otimizados para implantação em dispositivos finais com recursos limitados. Ele é direcionado a desenvolvedores, pesquisadores e organizações que buscam integrar poderosas capacidades de IA em ambientes de computação de borda sem sacrificar o desempenho. A plataforma oferece vários tamanhos de modelo (de 0.5B a 8B parâmetros) e recursos avançados como eficiência extrema através de arquiteturas otimizadas, algoritmos de aprendizado e sistemas de inferência, permitindo desempenho superior em tarefas como processamento de texto longo, chamada de ferramentas e interpretação de código.

Como usar MiniCPM

Os usuários podem interagir com o MiniCPM clonando seu repositório GitHub, que fornece acesso aos pesos do modelo e ao código de inferência. Os modelos estão disponíveis para download no HuggingFace e ModelScope. Para inferência, os usuários podem aproveitar vários frameworks otimizados como CPM.cu (recomendado para máxima eficiência), HuggingFace Transformers, vLLM, SGLang, llama.cpp, Ollama, fastllm e mlx_lm. O projeto também oferece guias detalhados para o ajuste fino do modelo usando ferramentas como LLaMA-Factory e para funcionalidades avançadas como chamada de ferramentas e interpretação de código. Como um projeto de código aberto sob a licença Apache-2.0, não há requisitos diretos de registro ou modelos de precificação; os usuários podem baixar e integrar livremente os modelos em suas aplicações.

Recursos principais de MiniCPM

Arquitetura LLM Ultraeficiente (InfLLM v2 para atenção esparsa)

Eficiência Extrema em Dispositivos Finais (aceleração de 5x+)

Ampla Gama de Modelos (0.5B a 8B parâmetros)

Quantização Avançada (BitCPM4 para quantização de 3 valores)

Suporte a Janela de Contexto Longa (até 128K, extensível a 131K+ com escalonamento RoPE)

Frameworks de Inferência Otimizados (CPM.cu, vLLM, SGLang, llama.cpp, PowerInfer)

Capacidade de Chamada de Ferramentas (MiniCPM4-MCP para interagir com mais de 16 servidores MCP)

Funcionalidade de Intérprete de Código

Geração Automatizada de Pesquisas (agente MiniCPM4-Survey)

Dados de Treinamento de Alta Qualidade (UltraClean, UltraChat v2)

Casos de uso de MiniCPM

Implantar assistentes de IA poderosos em telefones celulares, dispositivos domésticos inteligentes ou sistemas embarcados.

Desenvolver aplicações que exigem processamento em tempo real e eficiente de documentos longos ou conversas.

Construir agentes inteligentes capazes de interagir com ferramentas e APIs externas.

Automatizar a geração de revisões de literatura acadêmica ou resumos de pesquisa.

Integrar execução de código e resolução de problemas em ferramentas de desenvolvimento alimentadas por IA.

Aprimorar sistemas de Geração Aumentada por Recuperação (RAG) para melhor recuperação de informações.

Ajustar modelos de linguagem compactos para aplicações industriais especializadas com recursos computacionais limitados.

Habilitar capacidades de IA offline em vários eletrônicos de consumo e equipamentos industriais.

Pesquisa e desenvolvimento em IA eficiente e modelos de linguagem grandes.

Criar soluções de IA personalizadas que exigem alto desempenho em dispositivos de borda.