MiniCPM

| Einführung: | MiniCPM ist eine Reihe ultraeffizienter großer Sprachmodelle (LLMs), die für den Hochleistungs-Einsatz auf Endgeräten konzipiert sind und erhebliche Beschleunigungen sowie eine wettbewerbsfähige Leistung gegenüber größeren Modellen erzielen. |

| Aufgenommen am: | 6/9/2025 |

| Links: |

Was ist MiniCPM?

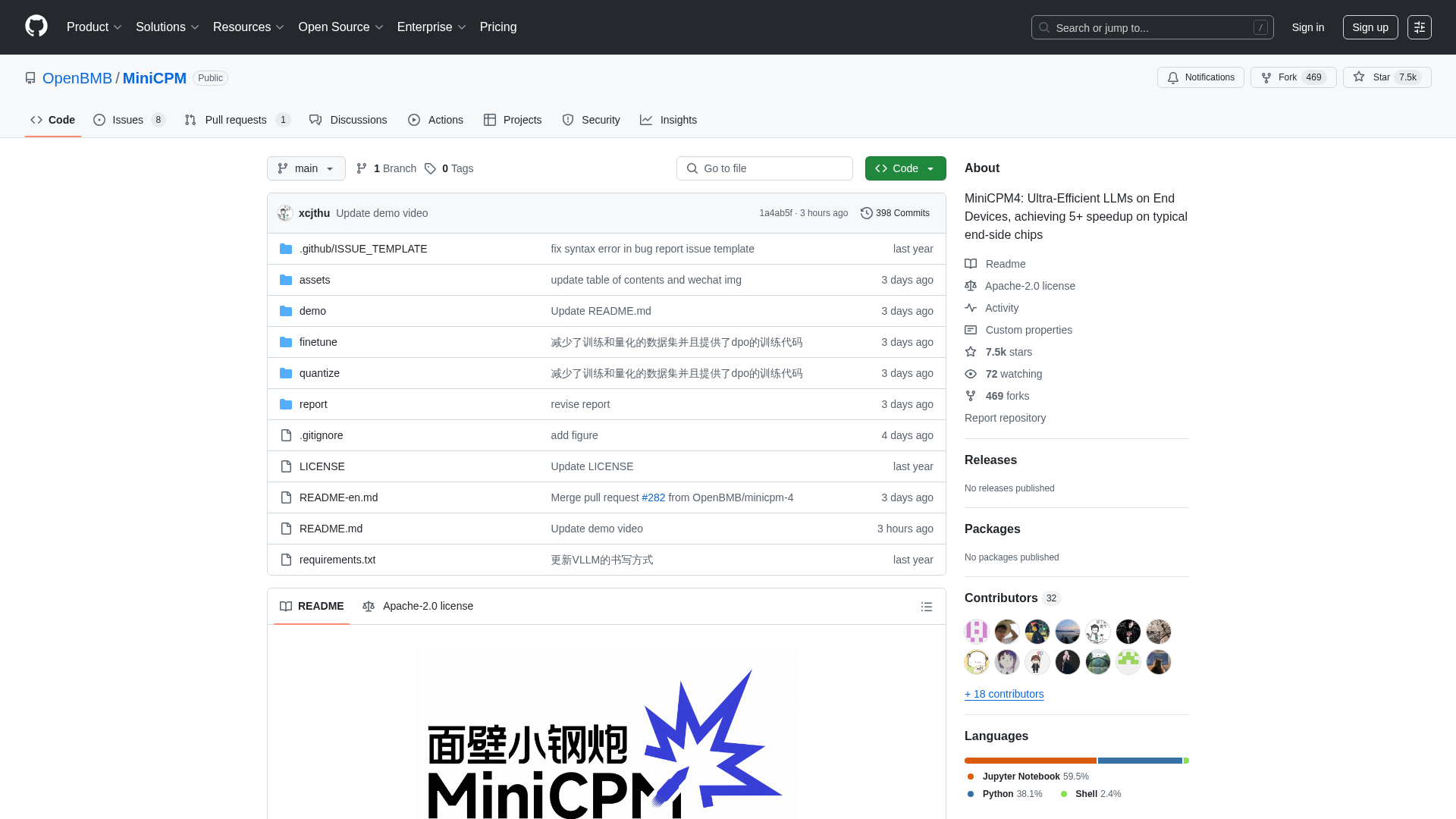

MiniCPM ist ein Open-Source-Projekt, das von OpenBMB, THUNLP und ModelBest entwickelt wurde und eine Familie hocheffizienter großer Sprachmodelle (LLMs) bietet, die für den Einsatz auf ressourcenbeschränkten Endgeräten optimiert sind. Es richtet sich an Entwickler, Forscher und Organisationen, die leistungsstarke KI-Funktionen in Edge-Computing-Umgebungen integrieren möchten, ohne Leistungseinbußen hinnehmen zu müssen. Die Plattform bietet verschiedene Modellgrößen (von 0,5 Mrd. bis 8 Mrd. Parametern) und fortschrittliche Funktionen wie extreme Effizienz durch optimierte Architekturen, Lernalgorithmen und Inferenzsysteme, die eine überragende Leistung bei Aufgaben wie der Verarbeitung langer Texte, dem Aufruf von Tools und der Code-Interpretation ermöglichen.

Wie verwendet man MiniCPM

Benutzer können mit MiniCPM interagieren, indem sie das GitHub-Repository klonen, das Zugriff auf die Modellgewichte und den Inferenzcode bietet. Die Modelle stehen auf HuggingFace und ModelScope zum Download bereit. Für die Inferenz können Benutzer verschiedene optimierte Frameworks wie CPM.cu (für maximale Effizienz empfohlen), HuggingFace Transformers, vLLM, SGLang, llama.cpp, Ollama, fastllm und mlx_lm nutzen. Das Projekt bietet auch detaillierte Anleitungen zur Feinabstimmung von Modellen mit Tools wie LLaMA-Factory und für erweiterte Funktionen wie Tool-Aufrufe und Code-Interpretation. Als Open-Source-Projekt unter der Apache-2.0-Lizenz gibt es keine direkten Registrierungsanforderungen oder Preismodelle; Benutzer können die Modelle frei herunterladen und in ihre Anwendungen integrieren.

Kernfunktionen von MiniCPM

Ultraeffiziente LLM-Architektur (InfLLM v2 für Sparse Attention)

Extreme Effizienz auf Endgeräten (5x+ Beschleunigung)

Breite Modellpalette (0,5 Mrd. bis 8 Mrd. Parameter)

Fortschrittliche Quantisierung (BitCPM4 für 3-Wert-Quantisierung)

Unterstützung langer Kontextfenster (bis zu 128K, erweiterbar auf 131K+ mit RoPE-Skalierung)

Optimierte Inferenz-Frameworks (CPM.cu, vLLM, SGLang, llama.cpp, PowerInfer)

Tool-Aufruffunktion (MiniCPM4-MCP für die Interaktion mit über 16 MCP-Servern)

Code-Interpreter-Funktionalität

Automatisierte Umfragegenerierung (MiniCPM4-Survey-Agent)

Hochwertige Trainingsdaten (UltraClean, UltraChat v2)

Anwendungsfälle von MiniCPM

Bereitstellung leistungsstarker KI-Assistenten auf Mobiltelefonen, Smart-Home-Geräten oder eingebetteten Systemen.

Entwicklung von Anwendungen, die eine effiziente Echtzeitverarbeitung langer Dokumente oder Konversationen erfordern.

Erstellung intelligenter Agenten, die mit externen Tools und APIs interagieren können.

Automatisierung der Erstellung von akademischen Literaturübersichten oder Forschungszusammenfassungen.

Integration von Code-Ausführung und Problemlösung in KI-gestützte Entwicklungstools.

Verbesserung von Retrieval-Augmented Generation (RAG)-Systemen für eine verbesserte Informationsbeschaffung.

Feinabstimmung kompakter Sprachmodelle für spezialisierte Industrieanwendungen mit begrenzten Rechenressourcen.

Ermöglichung von Offline-KI-Funktionen in verschiedenen Unterhaltungselektronik- und Industrieanlagen.

Forschung und Entwicklung im Bereich effizienter KI und großer Sprachmodelle.

Erstellung kundenspezifischer KI-Lösungen, die eine hohe Leistung auf Edge-Geräten erfordern.