MiniCPM

MiniCPMとは?

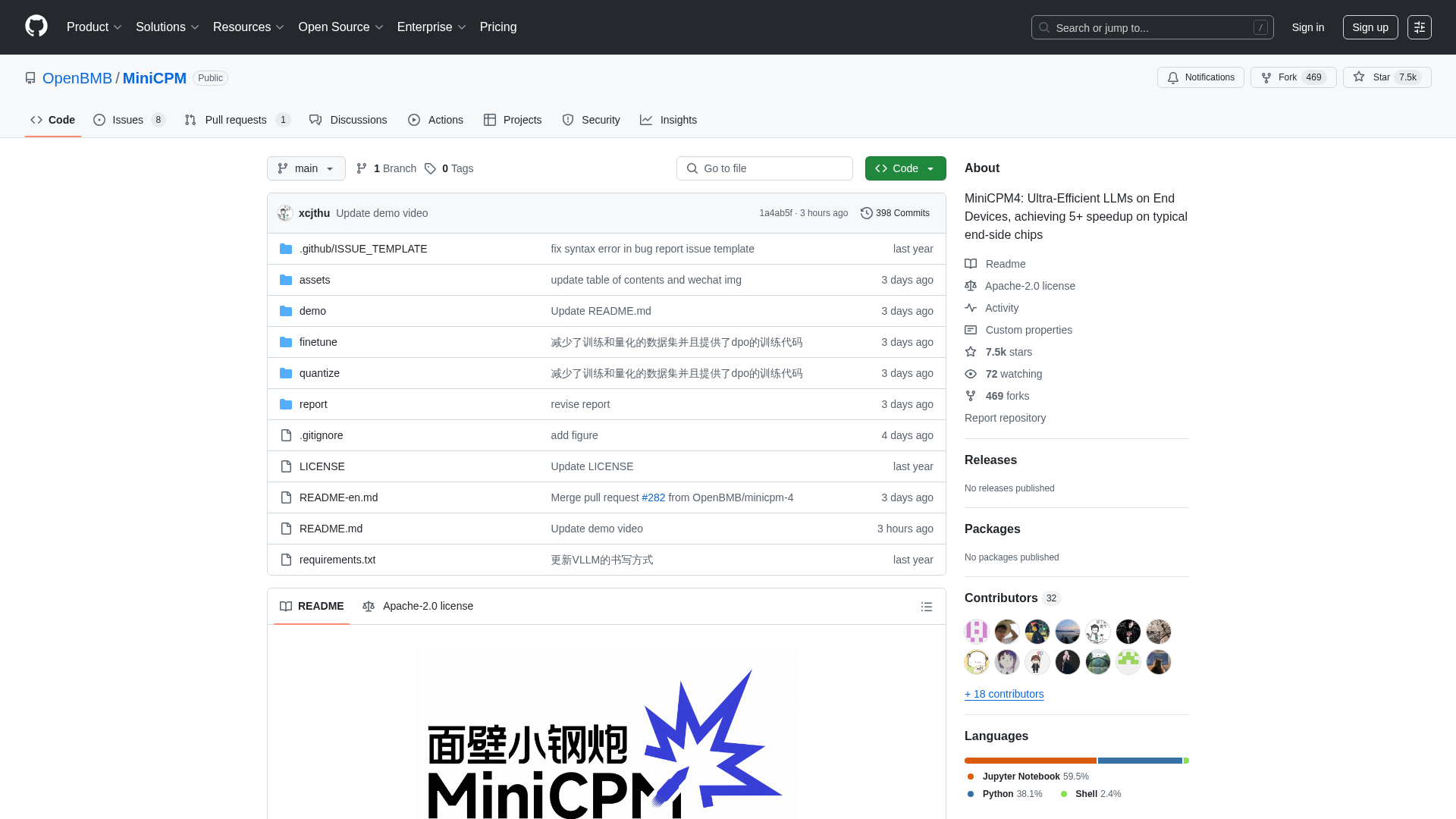

MiniCPMは、OpenBMB、THUNLP、ModelBestによって開発されたオープンソースプロジェクトであり、リソースが限られたエンドデバイスへの展開に最適化された、非常に効率的な大規模言語モデル(LLM)ファミリーを提供します。これは、パフォーマンスを犠牲にすることなく、強力なAI機能をエッジコンピューティング環境に統合しようとしている開発者、研究者、組織を対象としています。このプラットフォームは、さまざまなモデルサイズ(0.5Bから8Bパラメータ)と、最適化されたアーキテクチャ、学習アルゴリズム、推論システムによる極めて高い効率性などの高度な機能を提供し、長文処理、ツール呼び出し、コード解釈などのタスクで優れたパフォーマンスを可能にします。

MiniCPMの使い方

ユーザーは、MiniCPMのGitHubリポジトリをクローンすることで、モデルの重みと推論コードにアクセスできます。モデルはHuggingFaceおよびModelScopeからダウンロード可能です。推論には、CPM.cu(最高の効率性のため推奨)、HuggingFace Transformers、vLLM、SGLang、llama.cpp、Ollama、fastllm、mlx_lmなど、さまざまな最適化されたフレームワークを利用できます。このプロジェクトは、LLaMA-Factoryなどのツールを使用したモデルのファインチューニングや、ツール呼び出し、コード解釈などの高度な機能に関する詳細なガイドも提供しています。Apache-2.0ライセンス下のオープンソースプロジェクトであるため、直接的な登録要件や料金モデルはなく、ユーザーはモデルを自由にダウンロードしてアプリケーションに統合できます。

MiniCPMの主な機能

超効率的なLLMアーキテクチャ(疎なアテンションのためのInfLLM v2)

エンドデバイスでの極めて高い効率性(5倍以上の高速化)

幅広いモデル範囲(0.5Bから8Bパラメータ)

高度な量子化(3値量子化のためのBitCPM4)

長文コンテキストウィンドウのサポート(最大128K、RoPEスケーリングで131K以上に拡張可能)

最適化された推論フレームワーク(CPM.cu, vLLM, SGLang, llama.cpp, PowerInfer)

ツール呼び出し機能(16以上のMCPサーバーと連携するためのMiniCPM4-MCP)

コードインタプリタ機能

自動アンケート生成(MiniCPM4-Surveyエージェント)

高品質なトレーニングデータ(UltraClean, UltraChat v2)

MiniCPMの使用例

携帯電話、スマートホームデバイス、または組み込みシステムに強力なAIアシスタントを展開する。

長文のドキュメントや会話をリアルタイムで効率的に処理する必要があるアプリケーションを開発する。

外部ツールやAPIと連携できるインテリジェントエージェントを構築する。

学術文献レビューや研究要約の生成を自動化する。

AIを活用した開発ツールにコード実行と問題解決機能を統合する。

情報検索を改善するために、検索拡張生成(RAG)システムを強化する。

計算リソースが限られた特定の産業アプリケーション向けに、コンパクトな言語モデルをファインチューニングする。

様々な家電製品や産業機器でオフラインAI機能を有効にする。

効率的なAIと大規模言語モデルの研究開発。

エッジデバイスで高性能を必要とするカスタムAIソリューションを開発する。