MiniCPM

| Introducción: | MiniCPM es una serie de modelos de lenguaje grandes (LLM) ultraeficientes diseñados para una implementación de alto rendimiento en dispositivos finales, logrando aceleraciones significativas y un rendimiento competitivo frente a modelos más grandes. |

| Registrado en: | 6/9/2025 |

| Enlaces: |

¿Qué es MiniCPM?

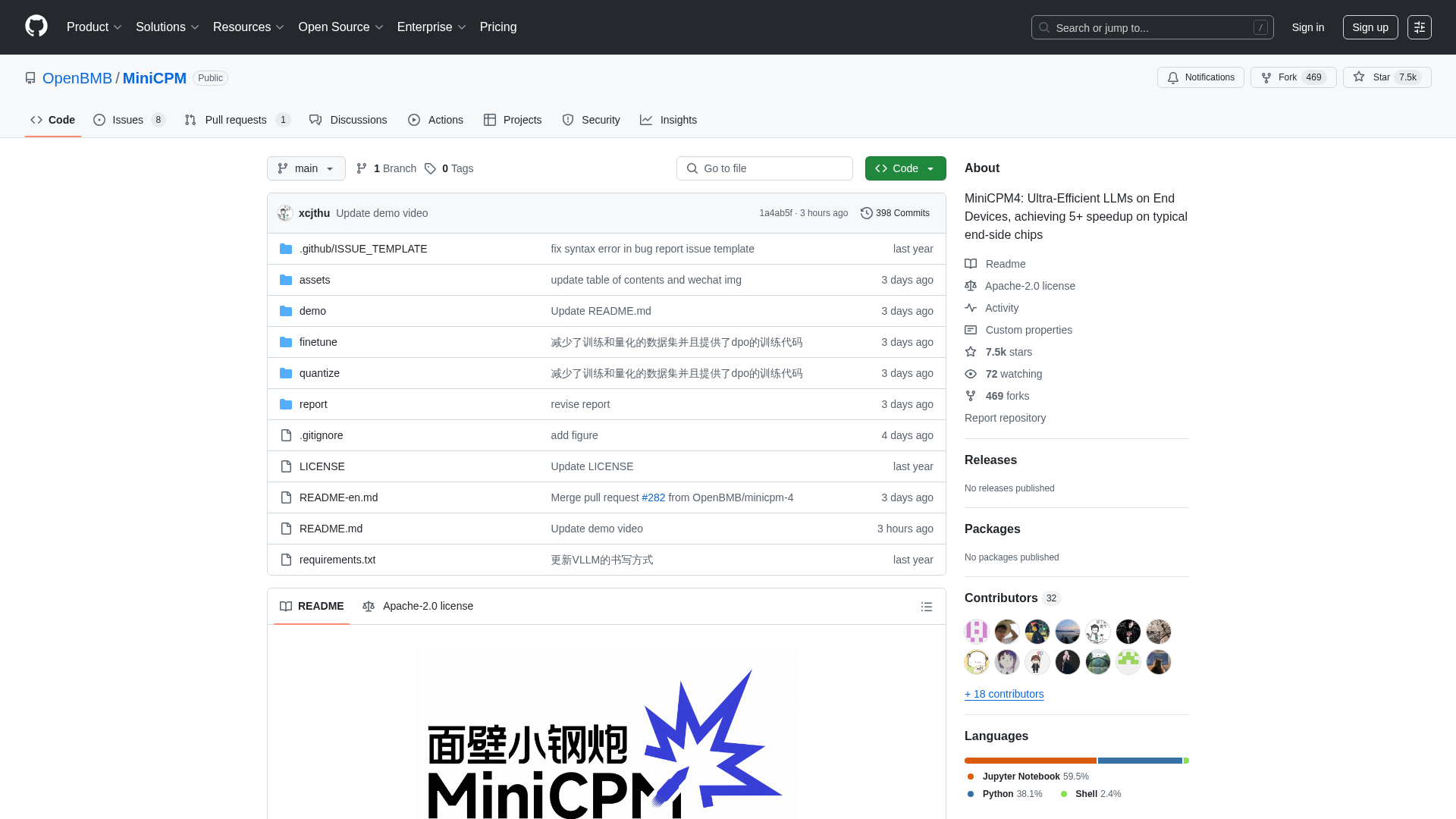

MiniCPM es un proyecto de código abierto desarrollado por OpenBMB, THUNLP y ModelBest, que ofrece una familia de modelos de lenguaje grandes (LLM) altamente eficientes optimizados para su implementación en dispositivos finales con recursos limitados. Está dirigido a desarrolladores, investigadores y organizaciones que buscan integrar potentes capacidades de IA en entornos de computación en el borde sin sacrificar el rendimiento. La plataforma proporciona varios tamaños de modelo (desde 0.5B hasta 8B parámetros) y características avanzadas como una eficiencia extrema a través de arquitecturas optimizadas, algoritmos de aprendizaje y sistemas de inferencia, lo que permite un rendimiento superior en tareas como el procesamiento de textos largos, la llamada a herramientas y la interpretación de código.

Cómo usar MiniCPM

Los usuarios pueden interactuar con MiniCPM clonando su repositorio de GitHub, que proporciona acceso a los pesos del modelo y al código de inferencia. Los modelos están disponibles para su descarga en HuggingFace y ModelScope. Para la inferencia, los usuarios pueden aprovechar varios frameworks optimizados como CPM.cu (recomendado para máxima eficiencia), HuggingFace Transformers, vLLM, SGLang, llama.cpp, Ollama, fastllm y mlx_lm. El proyecto también ofrece guías detalladas para el ajuste fino del modelo utilizando herramientas como LLaMA-Factory y para funcionalidades avanzadas como la llamada a herramientas y la interpretación de código. Como proyecto de código abierto bajo la licencia Apache-2.0, no hay requisitos directos de registro ni modelos de precios; los usuarios pueden descargar e integrar libremente los modelos en sus aplicaciones.

Características principales de MiniCPM

Arquitectura LLM Ultraeficiente (InfLLM v2 para atención dispersa)

Eficiencia Extrema en Dispositivos Finales (aceleración 5x+)

Amplia Gama de Modelos (de 0.5B a 8B parámetros)

Cuantificación Avanzada (BitCPM4 para cuantificación de 3 valores)

Soporte para Ventana de Contexto Larga (hasta 128K, extensible a 131K+ con escalado RoPE)

Frameworks de Inferencia Optimizados (CPM.cu, vLLM, SGLang, llama.cpp, PowerInfer)

Capacidad de Llamada a Herramientas (MiniCPM4-MCP para interactuar con más de 16 servidores MCP)

Funcionalidad de Intérprete de Código

Generación Automatizada de Encuestas (agente MiniCPM4-Survey)

Datos de Entrenamiento de Alta Calidad (UltraClean, UltraChat v2)

Casos de uso de MiniCPM

Despliegue de potentes asistentes de IA en teléfonos móviles, dispositivos de hogar inteligente o sistemas embebidos.

Desarrollo de aplicaciones que requieren procesamiento eficiente y en tiempo real de documentos o conversaciones largas.

Creación de agentes inteligentes capaces de interactuar con herramientas y APIs externas.

Automatización de la generación de revisiones de literatura académica o resúmenes de investigación.

Integración de la ejecución de código y la resolución de problemas en herramientas de desarrollo impulsadas por IA.

Mejora de sistemas de Generación Aumentada por Recuperación (RAG) para una mejor recuperación de información.

Ajuste fino de modelos de lenguaje compactos para aplicaciones industriales especializadas con recursos computacionales limitados.

Habilitación de capacidades de IA sin conexión en diversos productos electrónicos de consumo y equipos industriales.

Investigación y desarrollo en IA eficiente y modelos de lenguaje grandes.

Creación de soluciones de IA personalizadas que requieren alto rendimiento en dispositivos de borde.