MiniCPM

MiniCPM이란?

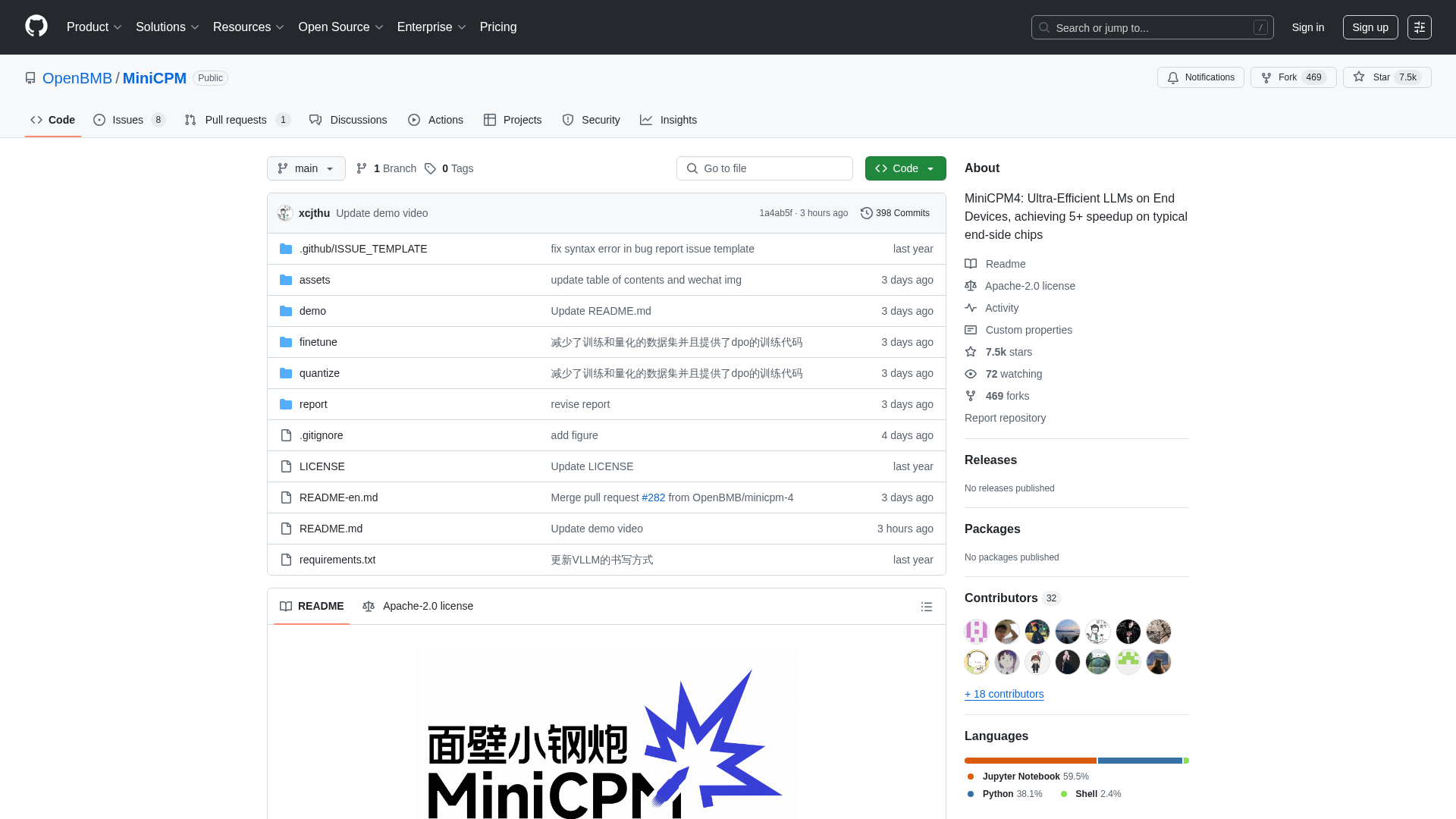

MiniCPM은 OpenBMB, THUNLP, ModelBest가 개발한 오픈 소스 프로젝트로, 리소스가 제한된 최종 기기에 배포하기 위해 최적화된 고효율 대규모 언어 모델(LLM) 제품군을 제공합니다. 이 프로젝트는 성능 저하 없이 엣지 컴퓨팅 환경에 강력한 AI 기능을 통합하려는 개발자, 연구원 및 조직을 대상으로 합니다. 이 플랫폼은 다양한 모델 크기(0.5B에서 8B 매개변수)와 최적화된 아키텍처, 학습 알고리즘 및 추론 시스템을 통한 극도의 효율성과 같은 고급 기능을 제공하여 장문 처리, 도구 호출, 코드 해석과 같은 작업에서 뛰어난 성능을 가능하게 합니다.

MiniCPM 사용 방법

사용자는 MiniCPM의 GitHub 저장소를 클론하여 모델 가중치와 추론 코드에 접근할 수 있습니다. 모델은 HuggingFace와 ModelScope에서 다운로드할 수 있습니다. 추론을 위해 사용자는 CPM.cu(최대 효율성을 위해 권장), HuggingFace Transformers, vLLM, SGLang, llama.cpp, Ollama, fastllm, mlx_lm과 같은 다양한 최적화된 프레임워크를 활용할 수 있습니다. 이 프로젝트는 또한 LLaMA-Factory와 같은 도구를 사용한 모델 미세 조정 및 도구 호출, 코드 해석과 같은 고급 기능에 대한 자세한 가이드를 제공합니다. Apache-2.0 라이선스 하의 오픈 소스 프로젝트이므로 직접적인 등록 요구 사항이나 가격 모델이 없으며, 사용자는 모델을 자유롭게 다운로드하여 자신의 애플리케이션에 통합할 수 있습니다.

MiniCPM의 주요 기능

초고효율 LLM 아키텍처 (희소 어텐션을 위한 InfLLM v2)

최종 기기에서의 극대화된 효율성 (5배 이상 속도 향상)

광범위한 모델 범위 (0.5B에서 8B 매개변수)

고급 양자화 (3값 양자화를 위한 BitCPM4)

긴 컨텍스트 창 지원 (최대 128K, RoPE 스케일링으로 131K+까지 확장 가능)

최적화된 추론 프레임워크 (CPM.cu, vLLM, SGLang, llama.cpp, PowerInfer)

도구 호출 기능 (16개 이상의 MCP 서버와 상호 작용을 위한 MiniCPM4-MCP)

코드 인터프리터 기능

자동 설문조사 생성 (MiniCPM4-Survey 에이전트)

고품질 학습 데이터 (UltraClean, UltraChat v2)

MiniCPM의 사용 사례

휴대폰, 스마트 홈 기기 또는 임베디드 시스템에 강력한 AI 비서 배포.

장문 문서 또는 대화의 실시간, 효율적인 처리가 필요한 애플리케이션 개발.

외부 도구 및 API와 상호 작용할 수 있는 지능형 에이전트 구축.

학술 문헌 검토 또는 연구 요약 생성 자동화.

AI 기반 개발 도구에 코드 실행 및 문제 해결 기능 통합.

정보 검색 개선을 위한 검색 증강 생성(RAG) 시스템 강화.

제한된 컴퓨팅 리소스를 가진 특정 산업 애플리케이션을 위한 소형 언어 모델 미세 조정.

다양한 가전제품 및 산업 장비에서 오프라인 AI 기능 활성화.

효율적인 AI 및 대규모 언어 모델 연구 개발.

엣지 기기에서 고성능이 요구되는 맞춤형 AI 솔루션 생성.