EnsembleCore AI

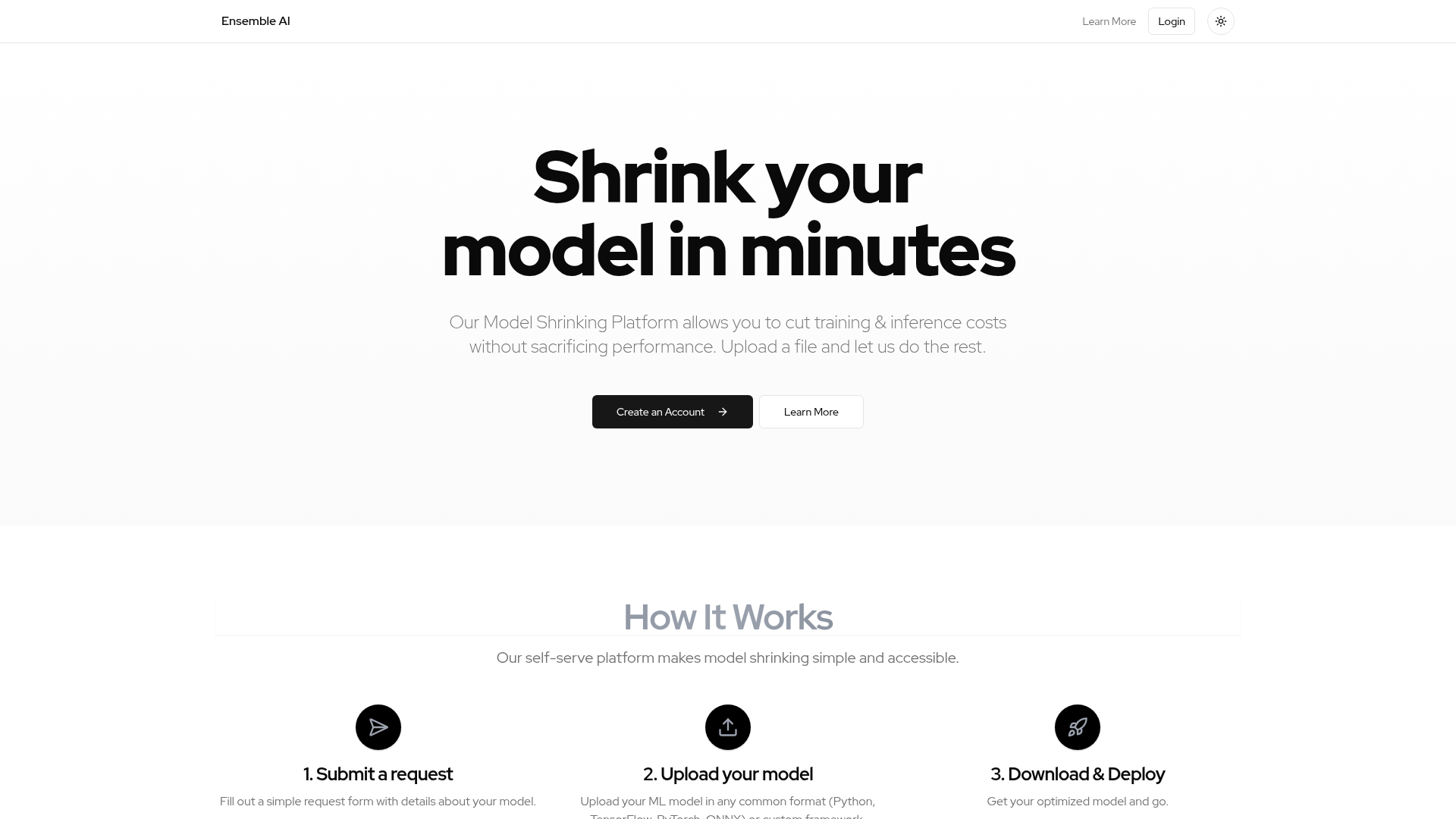

| Introdução: | EnsembleCore AI é uma Plataforma de Redução de Modelos projetada para diminuir os custos de treinamento e inferência para modelos de aprendizado de máquina sem sacrificar o desempenho. |

| Registrado em: | 6/4/2025 |

| Links: |

O que é EnsembleCore AI?

EnsembleCore AI é uma Plataforma de Redução de Modelos de autoatendimento que permite aos usuários reduzir significativamente os custos de treinamento e inferência associados aos seus modelos de aprendizado de máquina, tudo isso enquanto mantêm ou melhoram o desempenho. É projetada para desenvolvedores e organizações que trabalham com modelos de ML e que buscam eficiência e custo-benefício em suas operações de IA. A plataforma oferece um processo simplificado para otimizar modelos, tornando as técnicas avançadas de redução de modelos acessíveis a um público mais amplo.

Como usar EnsembleCore AI

Os usuários interagem com o EnsembleCore AI através de uma plataforma web simples e de autoatendimento. Para começar, os usuários precisam criar uma conta. O processo envolve três etapas principais: primeiro, enviar um formulário de solicitação com detalhes sobre o seu modelo; segundo, fazer o upload do seu modelo de aprendizado de máquina, que pode estar em formatos comuns como Python, TensorFlow, PyTorch, ONNX, ou até mesmo frameworks personalizados; e, finalmente, baixar o modelo otimizado pronto para implantação. A plataforma lida com o complexo processo de otimização automaticamente após o upload do modelo.

Recursos principais de EnsembleCore AI

Redução e otimização de modelos

Redução dos custos de treinamento e inferência

Preservação do desempenho do modelo

Suporte para múltiplos formatos de modelos de ML (Python, TensorFlow, PyTorch, ONNX)

Compatibilidade com frameworks de ML personalizados

Interface de plataforma de autoatendimento

Processo simples de envio de solicitação

Processo de otimização automatizado

Modelos otimizados para download

Casos de uso de EnsembleCore AI

Redução de custos operacionais para implantações de IA em larga escala.

Otimização de modelos para implantação em dispositivos de borda com recursos limitados.

Aceleração das velocidades de inferência para aplicações e serviços em tempo real.

Melhora da eficiência de pipelines de aprendizado de máquina em ambientes de produção.

Tornar modelos de linguagem grandes (LLMs) ou outros modelos complexos mais gerenciáveis e econômicos.

Simplificação dos fluxos de trabalho de implantação de modelos, fornecendo ativos otimizados.