EnsembleCore AI

| Einführung: | EnsembleCore AI ist eine Plattform zur Modellverkleinerung, die entwickelt wurde, um die Trainings- und Inferenzkosten für maschinelle Lernmodelle ohne Leistungseinbußen zu senken. |

| Aufgenommen am: | 6/4/2025 |

| Links: |

Was ist EnsembleCore AI?

EnsembleCore AI ist eine Self-Service-Plattform zur Modellverkleinerung, die es Benutzern ermöglicht, die mit ihren maschinellen Lernmodellen verbundenen Trainings- und Inferenzkosten erheblich zu senken, während die Leistung beibehalten oder sogar verbessert wird. Sie wurde für Entwickler und Organisationen entwickelt, die mit ML-Modellen arbeiten und Effizienz und Kosteneffizienz in ihren KI-Operationen anstreben. Die Plattform bietet einen optimierten Prozess zur Modelloptimierung, der fortschrittliche Modellverkleinerungstechniken einem breiteren Publikum zugänglich macht.

Wie verwendet man EnsembleCore AI

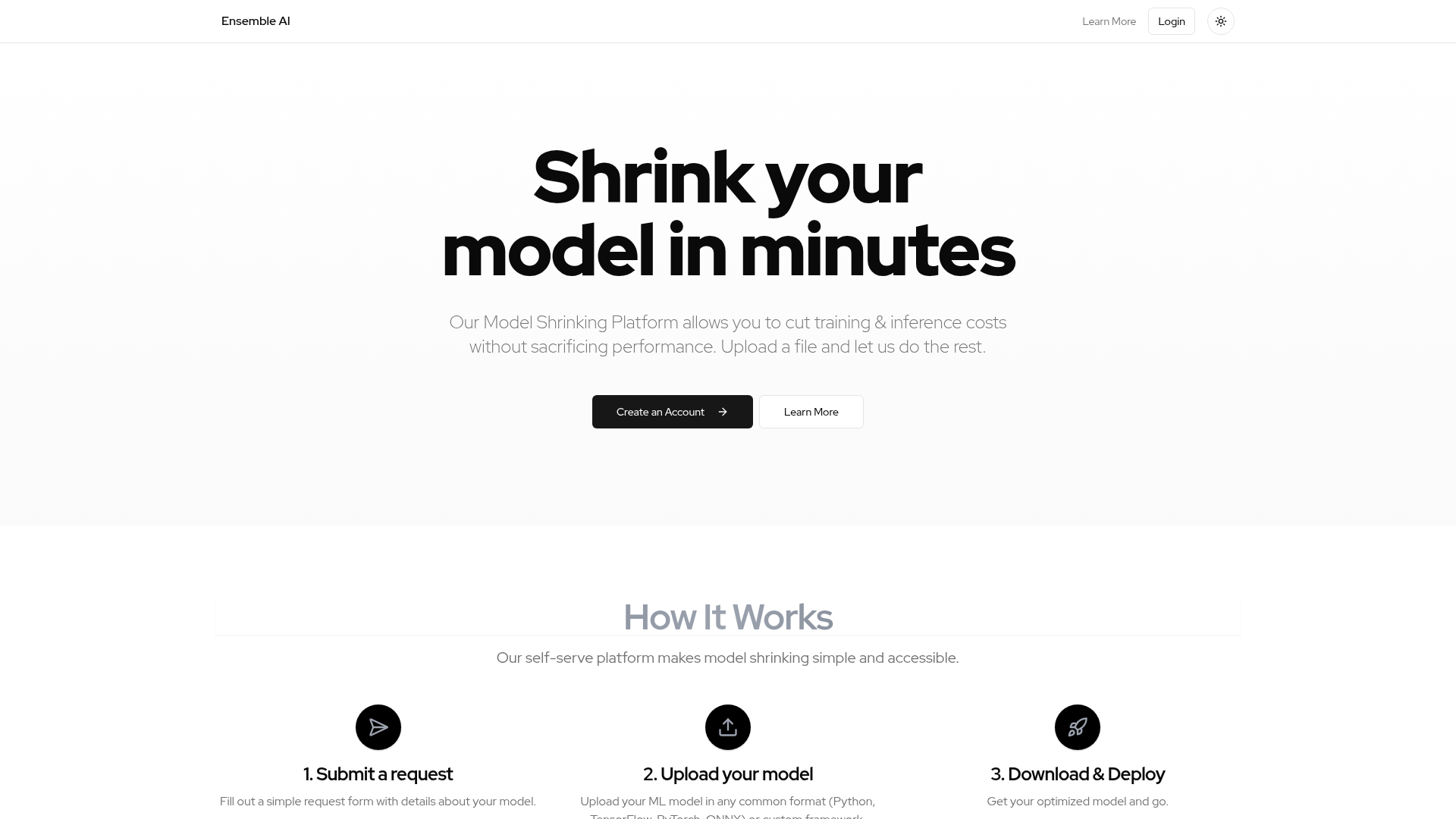

Benutzer interagieren mit EnsembleCore AI über eine einfache Self-Service-Webplattform. Um zu beginnen, müssen Benutzer ein Konto erstellen. Der Prozess umfasst drei Hauptschritte: Erstens, das Einreichen eines Anfrageformulars mit Details zu ihrem Modell; zweitens, das Hochladen ihres maschinellen Lernmodells, das in gängigen Formaten wie Python, TensorFlow, PyTorch, ONNX oder sogar benutzerdefinierten Frameworks vorliegen kann; und schließlich, das Herunterladen des optimierten Modells, das zur Bereitstellung bereit ist. Die Plattform übernimmt den komplexen Optimierungsprozess automatisch, nachdem das Modell hochgeladen wurde.

Kernfunktionen von EnsembleCore AI

Modellverkleinerung und -optimierung

Reduzierung der Trainings- und Inferenzkosten

Erhaltung der Modellleistung

Unterstützung mehrerer ML-Modellformate (Python, TensorFlow, PyTorch, ONNX)

Kompatibilität mit benutzerdefinierten ML-Frameworks

Self-Service-Plattformoberfläche

Einfacher Anfrageeinreichungsprozess

Automatisierter Optimierungsprozess

Herunterladbare optimierte Modelle

Anwendungsfälle von EnsembleCore AI

Reduzierung der Betriebskosten für groß angelegte KI-Bereitstellungen.

Optimierung von Modellen für die Bereitstellung auf ressourcenbeschränkten Edge-Geräten.

Beschleunigung der Inferenzgeschwindigkeiten für Echtzeitanwendungen und -dienste.

Verbesserung der Effizienz von Machine-Learning-Pipelines in Produktionsumgebungen.

Große Sprachmodelle (LLMs) oder andere komplexe Modelle handhabbarer und kostengünstiger machen.

Optimierung von Modellbereitstellungs-Workflows durch Bereitstellung optimierter Assets.